Il mantenimento dell’ottimizzazione SEO di una piattaforma web è una sfida a lungo termine, che deve essere portata avanti tenendo in considerazione numerosi aspetti, più o meno tecnici. Per rimanere competitivi e ottenere buone posizioni nelle SERP di Google è necessario non lasciare nulla al caso e costruire una strategia completa, rendendo il proprio sito appetibile ai motori e all’utenza. In questo articolo esploreremo gli errori e le dimenticanze più comuni, a cui chi non può contare sull’aiuto di un SEO specialist è frequentemente soggetto.

Nel caso avessi bisogno di assistenza, puoi affidarti ai nostri consulenti SEO per risolvere qualsiasi tipo di problematica legata all’ottimizzazione.

Non curare la crawlability

L’ottimizzazione del proprio posizionamento sui motori non può avvenire se il sito non è visibile e scansionabile dai bot che si occupano di indicizzare e valutare le pagine. Esistono diverse motivazioni per cui un sito web può avere problemi con i crawler, vediamo i più comuni:

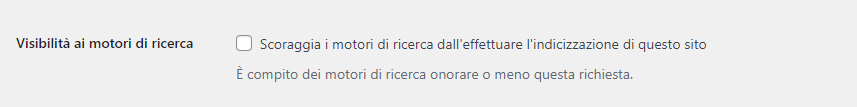

Impostazioni errate che scoraggiano le scansioni: se utilizzi un CMS controlla che non siano attive funzionalità per scoraggiare il crawling. Ad esempio su WordPress è presente l’opzione “Scoraggia i motori di ricerca dall’effettuare l’indicizzazione di questo sito” nella sezione Impostazioni → Lettura. Questa funzione è utile mentre il sito è ancora in costruzione ed è facile dimenticarsela attiva a lavori conclusi, facendo perdere tempo prezioso.

Sitemap non ottimizzata: La sitemap è uno strumento utile ai bot per orientarsi al meglio sul nostro sito web. È un file contenente tutti gli URL indicizzabili della piattaforma che gli spider sfruttano per comprendere la gerarchia dei vari contenuti è trovare le nuove pagine che vengono aggiunte, facendo risparmiare crawl budget. Per implementarla ci sono diversi modi. Il più semplice è tramite un plugin per il tuo CMS. WordPress ha a disposizione Yoast SEO. È anche possibile generare una sitemap con l’apposita funzione di Screaming Frog.

File robots scritto in modo erroneo: questo file di testo suggerisce ai crawler i percorsi da seguire ed evitare mentre effettuano la scansione. L’utilizzo di una regola errata può inficiare sulla visibilità dei contenuti: assicurati che non ci siano pagine utili con un Disallow. Ti ricordiamo che il file robots rimane solamente un suggerimento e che se vuoi assicurarti che un contenuto non venga indicizzato, dovrai utilizzare il tag noindex.

Avere tag non ottimizzati

I tag HTML hanno un gigantesco impatto sulle prestazioni SEO delle pagine.

Partendo dai meta tag, questi saranno la prima cosa che l’utente vedrà in SERP: avere Title e Meta Description ben scritti influenzerà il CTR (numero di clic sul risultato), uno dei fattori di ranking più importanti. Il title deve far comprendere all’utente di cosa parliamo e di conseguenza potrà contenere delle keyword utili. Inoltre, dovrà essere semplice ed accattivante per attirare l’attenzione. La sua lunghezza massima è di 60 caratteri. Con la meta-description potremo avere un po’ più di fantasia avendo a disposizione 160 caratteri. È consigliato inserire una CTA per aumentare il numero di clic.

Passiamo ai tag per la gerarchia del testo: gli headings. Questi vanno usati per dividere il testo in capitoli e sottocapitoli. L’H1 deve essere uno solo e venire utilizzato come titolo del testo, gli H2 suddivideranno i capitoli e gli H3 eventuali sotto-capitoli. Si può scendere nella gerarchia fino agli H6 ma è sconsigliato rendere la struttura del testo così complessa, soprattutto se questo non è molto lungo.

Non avere un sito veloce e facilmente navigabile

Google dedica particolare attenzione all’esperienza utente che offrono i portali. Un sito con problemi tecnici, caricamenti lenti o un layout poco intuitivo non farà strada. Assicurati di avere un piano di hosting che permetta caricamenti veloci ed evita di fare l’upload di contenuti multimediali troppo pesanti o di utilizzare tecnologie obsolete in grado di rendere la vita difficile ai bot (come Flash).

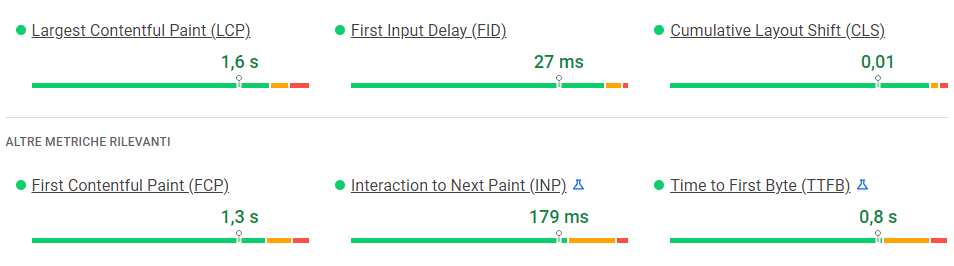

Dal 2021 Google ha anche introdotto i Core Web Vitals, una serie di parametri da rispettare riguardanti l’esperienza utente.

Le prestazioni del tuo sito possono essere misurate con Search Console e Page Speed Insight; qui potrai trovare un feedback sui tre parametri principali dei Core Web Vitals: FID, LCP e CLS.

Non gestire i redirect

Sono ancora in molti quelli che eliminano senza reindirizzamenti i contenuti obsoleti dalle proprie piattaforme senza sapere che lasciare una pagina in 404 è penalizzante. Ogni volta che è possibile si dovrà effettuare un reindirizzamento ad una pagina dal contenuto simile utilizzando un redirect permanente 301. Se una pagina è solo momentaneamente offline, invece, possiamo utilizzare il redirect 302. Esistono diversi modi per effettuare i redirect, ne abbiamo parlato approfonditamente nel nostro articolo dedicato.

Non rendere responsive la piattaforma

Da anni ormai i motori di ricerca vogliono che i siti web siano ottimizzati per la fruizione da qualsiasi dispositivo. Assicurati quindi, di avere una piattaforma con l’interfaccia responsiva, adatta a pc, tablet e smartphone di qualsiasi grandezza. Solitamente un buon tema di WordPress ben strutturato basta a risolvere il problema.

Non ottimizzare la struttura delle URL

Una URL “parlante”, scritta per far comprendere il contenuto della pagina, è da preferire a sequenze alfanumeriche. Una URL ottimizzata aiuta i bot a capire il contesto e a posizionare i tuoi contenuti.

Scrivere contenuti brevi e di scarsa qualità

Per essere al top delle SERP il nostro contenuto dovrà essere in grado di rispondere al meglio ai dubbi dell’utenza. Il testo oltre a dover rispettare la gerarchia HTML, dovrà essere accattivante, esaustivo e contenere le giuste keyword per aiutare Google a comprendere il contesto. Evitare assolutamente di avere contenuti duplicati o peggio copiati da altre piattaforme. Ogni testo dovrà essere unico.

Questa guida ti aiuterà a sbarazzarti delle problematiche più comuni della SEO ma ricorda che è sempre bene effettuare controlli periodici per rimanere sempre al passo con la concorrenza e gli aggiornamenti effettuati da Google.